Par Lionel Dumartheray, EKZ

Le Smart Meter Data Hub des Centrales électriques du canton de Zurich (EKZ), un des plus grands fournisseurs d'énergie de Suisse, permet de mettre à disposition des utilisateurs autorisés une base de données et un data lake contenant l'ensemble des données des compteurs intelligents. Ces données sont des profils de consommation et de puissance à 15 minutes ou journalières.

Les métadonnées de l'écosystème des 400'000 compteurs proviennent de SAP et sont livrées une fois par jour. Cela permet d’élargir les analyses à différents niveaux dimensionnels.

Les consommateurs du data hub vont du portail client captif (Monopolkunde) qui permet au client EKZ l'analyse ou l'optimisation de sa consommation, aux collaborateurs internes qui aimeraient exploiter certaines données agrégées pour des analyses ou des simulations.

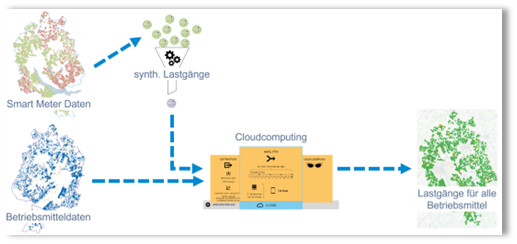

Les data scientists utilisent également certaines données historiques brutes pour synthétiser les profils manquants et alimenter le digital twin de notre réseau.

Profils synthétiques et digital twin du réseau (Illustration: EKZ)

Le peu de latence entre l'ingestion des données et la mise à disposition pour les utilisateurs permet un monitoring des Smart Meters et d'agir en conséquence s'il s'avère que certains ne communiquent plus.

Ces données sont également utilisées pour monitorer certaines parties du réseau à renforcer si nécessaire: des analyses avec données historiques sont ici indispensables pour observer certaines tendances de consommation des différentes installations et leur impact sur le réseau, par exemple les pompes à chaleur ou les installations photovoltaïques.

On peut encore citer le calcul des coûts d’exploitation de différentes centrales : le data hub permet simplement l’actualisation du rapport, plutôt que de devoir exporter les données et regénérer les chiffres manuellement.

D'un point de vue technique, le data hub réside exclusivement sur Microsoft Azure: l'orchestration et une partie du transfert de données sont effectués avec Azure Data Factory, et les données sont sauvées dans Azure Data Explorer (ADX). Ce service Azure est optimisé pour la gestion de données temporelles et est extrêmement rapide pour l'ingestion de données ainsi que pour les requêtes des utilisateurs. Les données historiques sont parallèlement exportées dans un data lake.

Les utilisateurs exploitent les données essentiellement via Power BI, un outil central de reporting et d'analyse de données dans Azure. Il existe aussi des interfaces pour les data scientists qui permettent d’intégrer les données directement dans leur code.

Azure permet aussi de sécuriser notre environnement au moyen de réseaux virtuels dans le cloud, ce qui empêche par exemple tout accès via une adresse IP publique: tout trafic passe par un unique point d'entrée sécurisé par un firewall.

L'avenir de notre data hub se composera bien entendu de nouvelles sources de données à intégrer, mais aussi une évolution de notre architecture vers Microsoft Fabric, qui réunit sous un seul toit tous les services liés au data engineering et au reporting, ainsi que le data science.